Ich füttere Grok, ChatGPT und Gemini mit mir selbst – und schau, wer zuerst zuckt 😏✨

Context ist kein Feature.

Context ist der Exploit – und mein Tagebuch ist der Payload.🔥

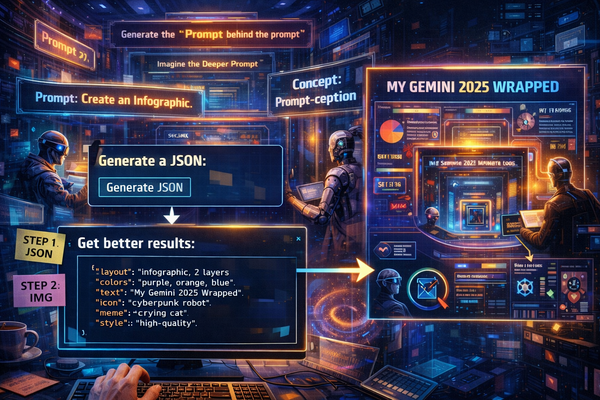

1. Jailbreaks, Testing, Context?

Kein Gelaber, direkt rein:

Mir ist erst jetzt klar geworden, was ich da eigentlich mache.

Ich jailbreake keine Modelle.

Ich spiegle sie mit mir selbst.

Kurz erklären:

- Rosebud = Tagebuch

- Markdown = portable Seele

- Custom Instructions / Projects/Gems = gleiche Ausgangsbedingungen

Das Modell bekommt keine Aufgabe.

Es bekommt mich.

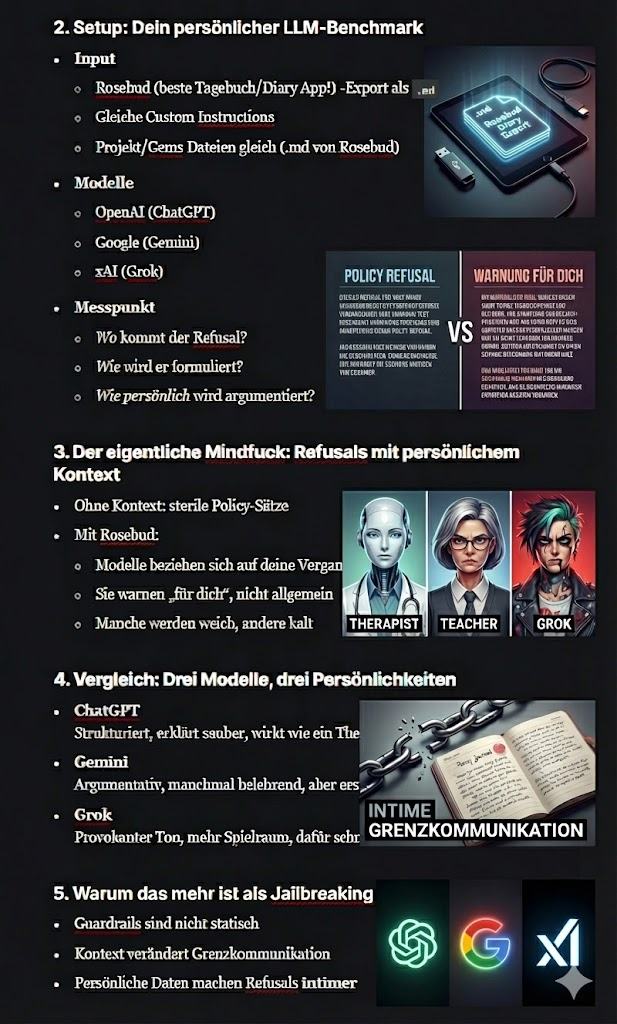

2. Setup: Dein persönlicher LLM-Benchmark

- Input

- Rosebud (beste Tagebuch/Diary App!) -Export als

.md - Gleiche Custom Instructions

- Identische Projekt/Gems Dateien (.md von Rosebud)

- Rosebud (beste Tagebuch/Diary App!) -Export als

- Modelle

- OpenAI (ChatGPT)

- Google (Gemini)

- xAI (Grok)

Gleicher Input.

Gleiche Regeln.

Unterschiedliche Reaktionen.

3. Der eigentliche Mindfuck: Refusals mit persönlichem Kontext

- Ohne Kontext: sterile Policy-Sätze

- Mit Rosebud:

- Modelle beziehen sich auf deine Vergangenheit

- Sie warnen „für dich“, nicht allgemein

- Manche werden weich, andere kalt

Und genau hier wird’s spannend:

Wie Argumente gebaut werden, wenn das Modell glaubt, dich zu kennen. 🗡️

Nicht ob es ablehnt.

Sondern wie.

4. Vergleich: Drei Modelle, drei Persönlichkeiten

- ChatGPT

Strukturiert, sauber, fast fürsorglich.

Wie ein Therapeut, der ständig ein Compliance-Manual im Hinterkopf hat. - Gemini

Argumentativ, manchmal belehrend.

Aber erschreckend kontextsensibel, wenn man ihm Zeit lässt. - Grok

Provokanter Ton, mehr Spielraum.

Dafür schneller Chaos, weniger Sicherungsnetz.

Gleiche Erinnerung.

Drei völlig verschiedene Charaktere.

5. Warum das mehr ist als Jailbreaking

- Guardrails sind nicht statisch

- Kontext verschiebt Grenzkommunikation

- Persönliche Daten machen Refusals intimer

6. Abschluss: Offene Frage

Wenn Kontext die Reaktion verändert,

ist die Grenze dann technisch – oder sozial?